È disponibile subito il podcast di oggi de Il Disinformatico della Radiotelevisione Svizzera, scritto, montato e condotto dal sottoscritto: lo trovate qui sul sito della RSI (si apre in una finestra/scheda separata) e lo potete scaricare qui.

Le puntate del Disinformatico sono ascoltabili anche tramite iTunes, Google Podcasts, Spotify e feed RSS.

Buon ascolto, e se vi interessano il testo di accompagnamento e i link alle fonti di questa puntata, sono qui sotto.

2024/07/27 00:20. Il testo è stato aggiornato per correggere un errore sul fatturato di Crowdstrike.

---

Titolo podcast: CrowdStrike, cronaca e cause di un collasso mondiale

[CLIP: inizio del TG serale RSI del 19 luglio 2024]

Questa storia inizia il 19 luglio 2024, un venerdì, precisamente alle 6 e 9 minuti del mattino, ora dell’Europa centrale. In quel momento una società di sicurezza informatica sconosciuta al grande pubblico diffonde ai propri clienti un aggiornamento molto piccolo, solo 40 kilobyte, meno di una singola foto di gattini [CLIP: voce di Trilli, la gatta dei vicini che abita con noi], che però manda in tilt circa 8 milioni e mezzo di computer Windows che lo ricevono e lo installano.

Sono computer che gestiscono banche, borse, ospedali, aeroporti, sistemi di pagamento, emittenti televisive e tanti altri servizi vitali. Non funziona praticamente più niente: non si vola, non si opera, si paga solo in contanti, ammesso di averli in una società sempre più cashless e contactless. Quel venerdì diventa uno dei più grossi collassi informatici mondiali di sempre, una sorta di Millennium Bug arrivato con 24 anni di ritardo.

Questa è la storia di come un singolo aggiornamento di un unico software ha mandato in tilt i sistemi informatici di mezzo mondo. Una storia che si può raccontare per bene, ora che la nebbia informativa delle prime ore si è diradata ed è stato pubblicato il rapporto tecnico sull’incidente, mentre i tecnici stanno ancora lavorando freneticamente per rimettere in funzione i propri computer e i criminali informatici approfittano del caos per colpire. Ma è anche la storia di chi si è scoperto immune al caos e di cosa si può fare per evitare che uno sconquasso del genere accada di nuovo.

Benvenuti alla puntata del 26 luglio 2024 del Disinformatico, il podcast della Radiotelevisione Svizzera dedicato alle notizie e alle storie strane dell’informatica. Io sono Paolo Attivissimo.

[SIGLA di apertura]

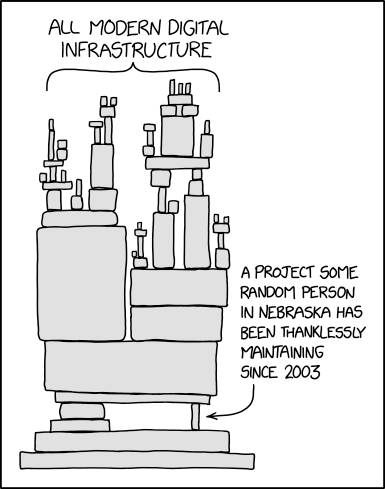

C’è una vignetta che ogni informatico conosce bene, pubblicata nel 2020 da Randall Munroe sul suo sito Xkcd.com. Raffigura una catasta pericolante di vari blocchi di dimensioni differenti, etichettata come “tutta l’infrastruttura digitale moderna”. Questa catasta poggia su due soli fragili punti d’appoggio, uno dei quali è un esile blocchetto, descritto come “un progetto che una persona a caso nel Nebraska gestisce dal 2003 senza neppure un grazie”. È una rappresentazione molto azzeccata di come si reggono molti dei sistemi informatici dai quali dipendiamo: stanno in piedi per miracolo e perché non tira il vento.

Al posto della persona a caso nel Nebraska, venerdì scorso c’era un’azienda del Texas, CrowdStrike, che ha circa ottomila dipendenti e un fatturato di circa tre miliardi di dollari l’anno [Sec.gov, pag. 13; nel podcast dico 100 milioni, ma è un dato riferito al 2017] e fornisce servizi di sicurezza informatica a gran parte delle società più importanti del pianeta, ma il risultato è stato praticamente lo stesso.

I fatti nudi e crudi pubblicati nel rapporto tecnico preliminare di CrowdStrike sull’incidente informatico planetario sono impietosi. L’azienda ha diffuso contemporaneamente a tutti i propri clienti un aggiornamento difettoso di un file di configurazione di un proprio prodotto di sicurezza, denominato Falcon, una sorta di super-antivirus destinato alle aziende.

Il difetto causava il crash dei computer Windows sui quali veniva installato, producendo una vistosissima schermata blu di errore che ha indotto molti a pensare che il guasto planetario fosse stato causato da un malfunzionamento di Windows, anche perché chi usa sistemi operativi diversi da Windows, come macOS, Unix o Linux, ha continuato a lavorare indisturbato.

Ma Microsoft in questo caso non c’entra. Infatti i tanti utenti privati di Windows e le tante piccole e medie imprese che usano Windows ma non adoperano CrowdStrike per la propria difesa contro gli attacchi informatici hanno continuato a lavorare come al solito.

CrowdStrike si è accorta del problema e ha smesso di diffondere l’aggiornamento difettoso un’ora e mezza dopo l’inizio della sua disseminazione, ma nel frattempo quell’aggiornamento aveva causato il crash di circa otto milioni e mezzo di computer nelle principali aziende del pianeta, secondo le stime di Microsoft.

Il problema è che questo tipo di crash non è risolvibile semplicemente riavviando il computer, come si fa di solito. Al riavvio, infatti, Windows carica di nuovo l’aggiornamento difettoso e va di nuovo in crash. Per uscire da questo circolo vizioso è necessario ricorrere a interventi manuali piuttosto complicati, che vanno fatti per ogni singolo computer colpito e spesso vanno fatti dando istruzioni a persone che non sono esperte ma sono le uniche che hanno fisicamente accesso ai computer in crisi.

Nei giorni successivi, Microsoft ha rilasciato uno strumento di recupero che semplifica leggermente il ripristino del funzionamento dei computer colpiti, ma comporta comunque la creazione di una chiavetta USB di avvio e l’esecuzione di una serie di istruzioni ben precise, e non è usabile sui computer nei quali le porte USB sono state bloccate o disabilitate per sicurezza e sui computer i cui dischi rigidi sono protetti dalla crittografia di Microsoft, denominata BitLocker, o da quella di altri prodotti analoghi. In questo caso, infatti, serve anche un codice di sblocco della crittografia.

In altre parole, i computer più difficili da rimettere in funzione sono proprio quelli più protetti, che sono tipicamente quelli installati in ruoli essenziali. Per gli addetti alla manutenzione dei sistemi informatici aziendali è stato un bagno di sangue, anche perché molto spesso i codici di sblocco sono custoditi per praticità... su altri computer Windows. E quei computer, essendo essenziali per la sicurezza aziendale, sono fra quelli che scaricano e installano immediatamente gli aggiornamenti di sicurezza e quindi sono anche loro in crash e inaccessibili [The Register].

È un po' come restare chiusi fuori casa perché si è rotta la chiave della porta d’ingresso e scoprire che la chiave di scorta, quella che abbiamo messo da parte per casi come questo, è dentro un cassetto chiuso a chiave. E la chiave di quel cassetto è in casa.

Mentre gli amministratori dei sistemi informatici colpiti ingeriscono dosi epiche di caffè e vedono sfumare il weekend e magari anche le ferie, la domanda che tanti si pongono è come possa accadere un disastro globale del genere e come si possa evitare che accada di nuovo.

La risposta è che CrowdStrike è quasi monopolista nel suo settore, e quindi un suo sbaglio ha effetti enormi su aziende che stanno al centro dell’economia mondiale. Servirebbe una diversificazione dei fornitori di sicurezza, e magari anche dei sistemi operativi, ma non c’è, e nessuno sembra interessato a richiederla.

Inoltre lo sbaglio in questione è avvenuto perché l’aggiornamento difettoso ha superato i controlli di sicurezza dell’azienda, come risulta dal rapporto tecnico preliminare. E li ha superati in ben due occasioni: la prima durante i controlli prima del rilascio, perché il software adibito al controllo, chiamato Content Validator, era a sua volta difettoso, e la seconda perché il software di CrowdStrike che riceveva l’aggiornamento, il cosiddetto Content Interpreter, non era in grado di gestire l’errore internamente e lo rifilava al sistema operativo, cioè Windows, che puntualmente andava in crash.

Questa sinfonia di errori ha poi trovato il suo gran finale nella scelta scellerata di diffondere l’aggiornamento a tutti i clienti contemporaneamente, che salvo emergenze assolute è una delle cose fondamentali da non fare assolutamente quando si aggiorna qualunque prodotto.

Come al solito, insomma, il disastro non è stato causato da un singolo difetto, ma da una catena di difetti, tutti piuttosto evidenti e prevedibili, e di eccessi di fiducia collettivi. Una catena che non ci si aspetta da un’azienda del calibro di CrowdStrike, che pure aveva una buona reputazione tra gli addetti ai lavori, avendo contribuito per esempio alle indagini sull’attacco nordcoreano alla Sony del 2014 e a quelle sulle fughe di dati ai danni del Partito Democratico statunitense nel 2015 e nel 2016.

I rimedi annunciati da CrowdStrike sono allineati con queste cause: il CEO dell’azienda, George Kurtz (ricordate questo nome), si è scusato profondamente per l’accaduto, e CrowdStrike dice che migliorerà i test interni da effettuare prima del rilascio dei suoi aggiornamenti e che adotterà la prassi dello staggered deployment, ossia del rilascio scaglionato, distribuendo gli aggiornamenti inizialmente a un gruppo di utenti ristretto per poi diffonderlo al resto della clientela solo dopo aver verificato che il gruppo ristretto non sta avendo malfunzionamenti. Inoltre darà alle aziende clienti la possibilità di selezionare quando e su quali loro computer vengono installati gli aggiornamenti.

Se state pensando che questi sono rimedi ovvi, che sarebbe stato opportuno adottare prima di causare un caos planetario, non siete i soli. Crowdstrike non è stata colpita dalla sfortuna di un evento improbabile, ma dalla concatenazione di malfunzionamenti perfettamente prevedibili. Ma come al solito, i soldi e la determinazione necessari per fare le cose per bene diventano sempre disponibili soltanto dopo che è successo il disastro evitabile.

E questa, purtroppo, è una prassi diffusa in moltissime aziende, non solo nel settore informatico. La domanda da porsi, forse, non è come mai sia successo questo incidente, ma come mai non ne succedano in continuazione, perché l’infrastruttura informatica mondiale è incredibilmente interdipendente e fragile. Per tornare a quella vignetta di Xkcd, l’informatica sta in piedi grazie a tanti omini del Nebraska che lavorano senza neppure un grazie. Perché finché le cose funzionano, la sicurezza e la qualità sono viste solo come un costo che disturba i profitti degli azionisti, e quando non funzionano è colpa degli amministratori dei sistemi informatici, fa niente se sono costretti a lavorare senza budget e senza personale.

Se siete uno o una di questi amministratori e state annuendo disperatamente perché vi riconoscete in questa descrizione, sappiate che non siete i soli, e che qualcuno, perlomeno, riconosce e apprezza il vostro lavoro. Grazie per le vostre notti insonni.

Intanto, però, c’è un altro gruppo di persone che ha reagito prontissimamente al caos informatico causato da CrowdStrike: i criminali informatici. Come avviene sempre in occasione di notizie che possono creare agitazione, confusione e panico, i malviventi ne hanno approfittato per tentare di mettere a segno i loro attacchi.

La società di sicurezza informatica Intego segnala infatti che il giorno stesso del collasso è iniziata la diffusione su Internet di falsi software di protezione, spacciati come rimedi preventivi da installare per evitare il blocco dei computer. Si tratta in realtà di malware, ossia di applicazioni infettanti, con nomi come Crowdstrike hotfix e simili. E i criminali informatici stanno ricorrendo a mail, SMS e anche telefonate per convincere le persone a installare questi falsi rimedi.

Se ricevete inviti a installare software di questo tipo, o se andate su Internet a cercare rimedi al problema di CrowdStrike, diffidate di qualunque fonte non verificata o verificabile e attenetevi soltanto alle istruzioni di Microsoft o di CrowdStrike pubblicate sui loro siti. E ricordate che questo problema non riguarda tutti gli utenti di Windows, come molti media generalisti hanno fatto pensare, ma solo le aziende che hanno installato CrowdStrike, per cui è molto probabile che non abbiate alcun bisogno di aggiornamenti di nessun genere per proteggervi da questa situazione.

E per finire, una chicca: nel 2010 ci fu un incidente analogo a questo, quando un aggiornamento difettoso del software di sicurezza di McAfee fece crollare gran parte di Internet, cancellando per errore i file di sistema dei computer Windows XP che usavano il software di McAfee. All’epoca, il responsabile in capo della sicurezza di McAfee era George Kurtz. Quello che oggi è CEO di CrowdStrike.