Ultimo aggiornamento: 2018/04/15 01:00.

Pochi giorni fa ho provato personalmente l’Autopilot più recente di Tesla e ora mi è molto più chiara la dinamica dell’incidente che è costato la vita a un utente di una Model X, Walter Huang, su un’autostrada californiana meno di un mese fa. Per questo credo che sia importante scrivere un chiarimento e lanciare pubblicamente un monito a tutti coloro che usano le Tesla e le altre auto a guida assistita: non fidatevi eccessivamente di questi sistemi e rispettatene scrupolosamente i limiti restando sempre pronti a intervenire, perché commette errori estremamente pericolosi.

Riassumo la dinamica dell’incidente, descritta in dettaglio qui: a una biforcazione di un’autostrada presso Mountain View, la Tesla di Huang ha colpito frontalmente la testata dello spartitraffico in cemento che divide le due carreggiate. L’attenuatore d’urto dello spartitraffico era già stato distrutto da un incidente precedente di un’auto convenzionale e quindi l’impatto è stato violentissimo.

I dati di bordo indicano che al momento dell’impatto il sistema di guida assistita (non autonoma) dell’auto, denominato Autopilot, era stato attivato da Huang. Il sistema aveva avvisato Huang ripetutamente di riprendere il controllo e le mani del conducente non erano sul volante nei sei secondi precedenti la collisione. Huang non ha intrapreso alcuna azione correttiva.

La vedova di Huang si appresta ora a fare causa a Tesla per la morte del marito e Tesla ha risposto con toni decisamente insoliti per una casa automobilistica, dando inequivocabilmente la responsabilità dell’incidente a Huang:

[...] Secondo la famiglia, il signor Huang era ben consapevole che l’Autopilot non era perfetto e aveva detto specificamente alla famiglia che non era affidabile proprio in quel luogo, eppure ha attivato l’Autopilot in quel luogo. L’incidente è avvenuto in una giornata limpida, con alcune centinaia di metri di visibilità anteriore, e questo significa che l’unico modo in cui questo incidente può essere accaduto è che il signor Huang non stava prestando attenzione alla strada nonostante il fatto che l’auto abbia fornito numerosi avvisi di farlo. [...]

Il comunicato integrale di Tesla è qui su Bloomberg.

Ma come mai l’Autopilot della Tesla di Huang ha sbagliato così disastrosamente? L’ho visto all’opera personalmente durante un recente viaggio su una Model S P100D dotata della versione più recente del sistema di guida assistita. Il mantenimento di corsia si basa fondamentalmente sulle telecamere di bordo, che rilevano le strisce che delimitano le corsie. Ma basta poco per confondere questo rilevamento.

Nel mio caso, su un tratto libero di autostrada svizzera nel quale erano state aggiunte delle strisce provvisorie per dei lavori, l’Autopilot ha riconosciuto ripetutamente soltanto le strisce bianche normali e quindi ha iniziato a sbagliare l’inserimento in corsia, spostandosi verso l’area dei lavori. Ma il conducente, accanto a me, era pronto a intervenire, come è giusto che sia e come Tesla ribadisce costantemente ad ogni attivazione dell’Autopilot, e quindi lo scostamento è stato minimo.

Senza l’intervento del conducente, però, le conseguenze sarebbero state preoccupanti. Proprio per questo Tesla visualizza promemoria e allarmi visivi e acustici molto chiari, arrivando a disabilitare l’Autopilot fino alla sosta successiva se il conducente ignora gli allarmi e non rimette le mani sul volante.

Nel caso di Huang, la striscia di sinistra della sua corsia si divideva a Y presso la biforcazione, creando un tratto nel quale la striscia sdoppiata formava una sorta di corsia fantasma che termina proprio contro lo spartitraffico.

|

| La zona dell’incidente in Google Maps, secondo i dati di Mercury News. L’auto proveniva da sinistra; lo spartitraffico è sulla destra. |

|

| La zona dell’incidente in Google Street View. |

L’ipotesi più plausibile è che l’auto abbia interpretato questa corsia fantasma come una corsia reale, usando come riferimento la striscia di sinistra e quindi interpretando la corsia fantasma come proseguimento di quella reale che stava occupando, e vi si sia posizionata. Il radar di bordo non avrebbe individuato lo spartitraffico, forse a causa del suo accartocciamento che lo rendeva poco riflettente al segnale emesso dall’auto.

|

| Un’altra Tesla compie lo stesso errore nello stesso punto. Immagine tratta da questo video. |

L’incapacità dell’attuale Autopilot di gestire questa configurazione stradale è evidenziata in questo video, che si riferisce a un’altra biforcazione:

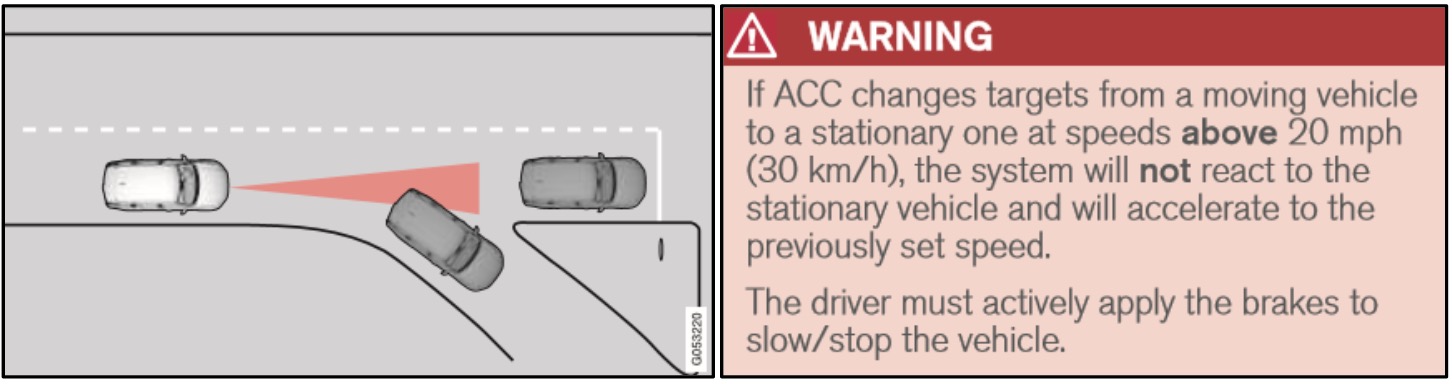

I dati raccolti dagli enti di sicurezza (NHTSA, pagina 11) indicano che in generale l’Autopilot riduce gli incidenti rispetto alle stesse auto guidate manualmente, ma questo non vuol dire che lo si debba usare intenzionalmente al di fuori dei suoi limiti di competenza, che sono molto evidenti: è un ottimo ausilio nelle code o su autostrade libere e con segnaletica orizzontale ben demarcata, ma si confonde molto facilmente in molte altre situazioni, come fanno del resto i sistemi delle altre marche.

|

| Dal manuale della BMW Serie 7 del 2016. Fonte: NHTSA. |

|

| Dal manuale della Volvo XC90 del 2016. Fonte: NHTSA. |

Nessun commento:

Posta un commento